アリババ生成AI・Qwen3がo1に比肩?中国製最新AIが米国製を凌駕しかける

●この記事のポイント

・中国EC大手・アリババ集団は、生成AIのLLM最新版として「Qwen3」をリリース

・「Qwen3-235B-A22B」は複数のベンチマークにおいて、米OpenAIの「o1」を上回っているとしている

・「ハイブリッド推論モデル」を導入し、高いコストパフォーマンスを実現

中国EC大手・アリババ集団は、生成AIのLLM(大規模言語モデル)最新版として「Qwen3」をリリースした。フラッグシップモデルである「Qwen3-235B-A22B」は複数のベンチマークにおいて、米OpenAIの「o1」や中国DeepSeek(ディープシーク)の「DeepSeek-R1」を上回っているとしている。使用するパラメータの数を少なくすることで、処理速度の向上とコスト削減を両立。また、推論のために複雑な思考を行うモードと単純な思考を行うモードを切り替える「ハイブリッド推論モデル」を導入し、高いコストパフォーマンスを実現できるという。今年1月にディープシークが「R1」を発表し、先月には百度(バイドゥ)が「文心大模型4.5ターボ」を発表するなど、中国では大手IT企業による生成AIモデルの開発競争が過熱化している。アリババの「Qwen3」はどのような特徴・優位性のあるLLMなのか。また、他社のモデルと比較して大きく性能が上回っているといえるのか。専門家の見解を交えて追ってみたい。

●目次

驚異的な高精度 即時応答型と思考型をシームレスに統合 エージェントを訓練することに重点を置いた時代へと移行 今回アリババが発表したのは、以下の計8つのモデル。

・MoEモデル(得意分野を持つ複数の小さなモデルを組み合わせて回答を生成するモデル。より高い性能が発揮される)

「Qwen3-235B-A22B」

「Qwen3-30B-A3B」

・Denseモデル(大きな1つのモデルのみ学習させるモデル)

「Qwen3-32B」

「Qwen3-14B」

「Qwen3-8B」

「Qwen3-4B」

「Qwen3-1.7B」

「Qwen3-0.6B」

前世代のQwen2.5からの進化としては、前述の「ハイブリッド思考」の実装に加え、AIエージェント用MCPのサポート強化などが挙げられる。

驚異的な高精度AI開発・研究者でメタデータ社長の野村直之氏は、前世代のQwen2.5に出会ったときの衝撃について、次のようにいう。

「弊社がhatBridという高精度RAG(検索拡張生成:大規模な言語モデルの出力を最適化するプロセス)製品を2023年4月にリリースしてから約1年後の24年初夏の頃のことでした。90%以上の高精度でハルシネーション(誤回答)のほとんどないRAGを求める現場は、極めて機密性の高い内部情報や専門知識を扱うことが多いため、RAG本体だけでなくLLMもダウンロードしてオンプレミス対応できるRAGを追求して、弊社は実験を繰り返していました。24年8月に、その時点で日本語で最高精度のRAGを組んだMetaのLlama3.1 70B, 8Bを採用して、ChatBridORをリリースしました。その後もさまざまなローカルLLMを試してきました。24年11月に弊社が6000名にお送りしたメールでは、Qwen2.5の日本語精度に驚愕した経緯を次のように語っています。

<最新ローカルLLMの社内評価結果速報

・DL利用のローカルLLMに“非常に小型”のものやマルチモーダル版が出現

Google社のGemma 2B JPNや、Meta社のLlama3.2 3B, 1B、そして13B(マルチモーダル)が代表的。小型軽量な分、推論速度が2〜4倍(8B比)となっています。同量のデータでファインチューニングを行った場合、大規模版よりも大きくカスタマイズできることも期待され、個別用途、エッジコンピューティングに向いています。実際、メタデータ社内の高性能GPUでこれらを4bit量子化したところ、僅か4GBのGPU VRAM搭載の、10万円程度のゲーミングノートPC上でも実用になることがわかりました。また、Google自身が精選された日本語データで学習させたGemma 2B JPNは、6.5倍規模の国産モデルの一部を大きく凌駕する精度を出しています。(いずれもメタデータ社内規約等の標準的な日本語マニュアル類で評価)

・70Bクラスの中規模LLMも充実。Alibaba製のQwen2.5が驚異的な高精度

驚きました。多言語学習済のQwen2.5 は特に日本語追加学習せずとも、一見 GPT 4やClaude3と見まごうばかりの高精度をたたき出しています。上記のマニュアル類ばかりでなく、複雑難解な官庁文書でもLlama3.1 70Bを凌駕する精度です。Qwen2.5は、世界中で競ってチューニングされ、さらに精度を高めた派生モデルも現れています。日本語用のチューニングでないにもかかわらず、はるかにお金をかけた、460Bの純国産モデルよりも、日本語の理解力で遥かに上をいっていると思われます。

70Bクラスの快適動作には、80GB以上のGPU VRAMを推奨しておりましたが、量子化・メモリ節約技術の進化で、2025年は32GBで快適動作するようになることが確実。すなわち次のBlackwell世代、民生用 RTX5090で十分となります。法人としては人件費比でタダ同然のハードウェア初期投資で、ほとんどの用途に十分な精度のLLMをローカルで動かせるわけです。セキュリティが心配だからと生成AIを忌避する理由が来年早々に消滅します。(ローカルLLMの他のメリット8つについて他詳細はニュースリリースページ下方の添付資料「ChatBridOR: 完全オンプレミスRAGシステム」をご参照ください)>」

即時応答型と思考型をシームレスに統合 Qwen3の性能は、他社のLLMと比較してどう評価できるのか。

「Qwen3の詳細、競合LLMとの精度比較については、こちらをご覧ください。

https://qwenlm.github.io/blog/qwen3/

要約すると、次のようなポイントが挙げられています。

・もっぱらWeb上の情報から集めたQwen2.5の18兆トークンの事前学習用データに加え、PDF文書などをQwen2.5により品質向上させて、119の言語と方言(上記ページのMultilingual Support欄にその一覧)をカバーする約36兆トークンで事前学習

・GPT 4o, DeepSeek V3のような即時応答型と、o1, o3, DeepSeek R1のような思考型をシームレスに統合(OpenAIのGPT5がそうなるとサム・アルトマンCEOが言っていたのを先取り)

・Qwen3の235B-A22B、Qwen3-32Bは、事前学習後に(1)長い思考連鎖(CoT)のコールドスタート、(2)推論に基づく強化学習(RL)、(3)思考モードの融合、(4)一般的なRLという、4段階の事後トレーニングにより実装。

・小型のモデル、Qwen3-30B-A3B、Qwen3-14B/8B/4Bは、Qwen3 235B-A22B、Qwen3-32Bからの『蒸留』により高精度をなるべく維持したまま小型化

・(規制の緩い)Apache 2.0ライセンスで商用利用可能

・AIエージェント実装には、Qwen-Agentライブラリが提供され、エージェントのデフォルトインタフェース規格となりつつあるMCP設定ファイルを定義するだけで、外部ツールを呼び出し実行させられるようになった」(野村氏)

前出のGitHubには、Qwen3の今後の方向性も記載されているという。

「今後の方向性、課題が末尾に記されていますが、これについては解釈の余地がいろいろあるため、原文に忠実ながら筆者の解釈も一部交えて以下に和訳します。その解釈は読者に委ねたいと思います(野村氏)。

<今後の課題:

Qwen3は、人工知能(AGI)および人工超知能(ASI)に向けた我々の旅において、重要なマイルストーンとなります。事前学習と強化学習(RL)の両方をスケールアップすることで、私たちはより高いレベルの知能を実現しました。思考モードと非思考モードをシームレスに統合し、ユーザーが思考に費やすコストの大小を柔軟にコントロールできるようにしました。 さらに、幅広い言語のサポートを拡大し、グローバルなアクセシビリティを強化しました。

将来的には、多彩な局面でモデルを強化することを目指しています。これには、データのスケーリング、モデルサイズの拡大、コンテキストの長さの拡張、(画像他への対応などの)モダリティの拡大、長大なプロセスの推論のための環境フィードバックによる強化学習の進展など、いくつかの重要な目的を達成するためのモデルアーキテクチャとトレーニング手法の改良が含まれます。 我々は、モデルを訓練することに重点を置いた時代から、エージェントを訓練することに重点を置いた時代へと移行しつつあると信じています。 私たちの次のAI訓練ステージでは、すべての人の仕事と人生に有意義な進歩をもたらすことを約束します>」

(協力=野村直之/AI開発・研究者、メタデータ株式会社社長、東京大学大学院医学系研究科研究員)

あわせて読みたい

-

- 通勤・出張もこの一つで。シンプル設計に多機能を凝縮した【エレコム】の大容量バックパックがAmazonで販売中!

- ウォーカープラスは、Amazon.co.jp を宣伝しリンクすることによってサイトが紹介料を獲得できる手段を提供…

- (Walkerplus)[旅]

-

- 66歳男性・資産3500万円で月の年金11万円「働かなくても年金がもらえて、焦りや不安もない」ゆとりの老後

- 老後の心配事といえば、やはりお金。現役時代にいくら稼ぎ、貯蓄をしておけば安心した暮らしができるのか…

- (All About)[省エネ]

-

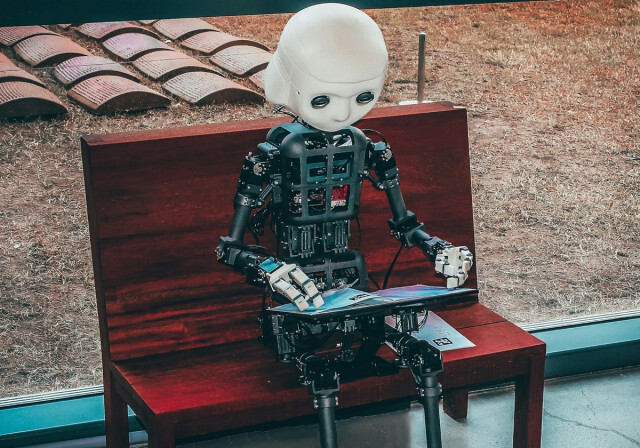

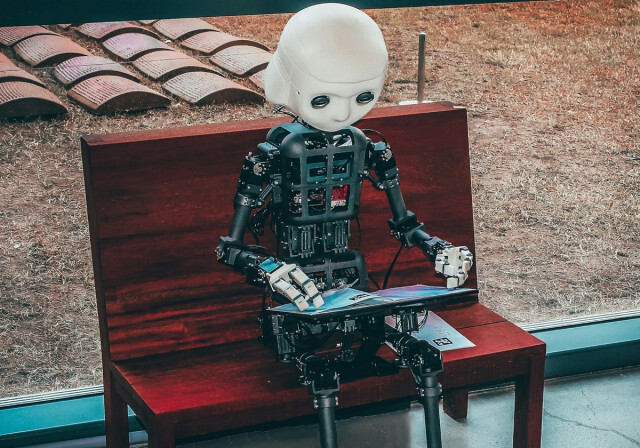

- どんなタオルも畳めるロボット、なぜ存在しない?AIで職業を代替が困難な理由

- 「Unsplash」より●この記事のポイント ・職業や仕事をAIに置き換えるためには、職業や仕事の内容をAI向け…

- (Business Journal)[ビジネスジャーナル]

-

- いつの間にか貧乏思考に…お金持ちになりたいときに気をつけたい「考え方」とは?

- お金に対する考え方は、友人や周囲の人の影響を受けやすいもの。もし、付き合う人が「貧乏思考」を持って…

- (All About)[ESG]

キーワードからさがす

CYZO.inc